テクノロジカルマーケティング部データマーケティンググループにてデータサイエンティスト兼UXアーキテクトをしている新保と申します。普段は機械学習を中心としたデータ活用の推進や新規機能のユーザ体験の設計をしています。ここ1年程リブセンスではサービスの戦略レイヤーや主要機能と結合度の高い領域に対して機械学習を適用していくことに挑戦しており、今回はそれらを実際にどのように行っているかをご紹介したいと思います。

パッチ型機械学習の成功体験とその限界

本題に入る前にリブセンスのデータ活用の歴史について少しお話しします。以前に別のメンバーが投稿した記事に詳しい説明がありますがリブセンスでは2014年にデータ活用の専門組織を立ち上げてから現在に至るまで機械学習のビジネス活用を継続的に行っています。初期の頃は既存サービスの枠組みの中でサービスとの結合度が出来る限り低く、かつ利益インパクトが大きい領域に機械学習を適用することからスタートし、比較的早い段階で成功を収めています。2015年にはレコメンドシステムやアトリビューションモデルなどが主要サービスに本格導入され、当時の全社売上50億円規模に対して安定的に年間1〜2億円程度の利益インパクトを残せるようになりました。一方で成功を収めたことでより高次の新しい課題が見え始めたのもこの時期です。課題の1つは機械学習の開発環境の整備です。こちらについては過去の記事に詳しく解説されていますので

マルチコンテナ構成による機械学習アルゴリズムとアプリケーションの疎結合化 - LIVESENSE Data Analytics Blog

などを御覧ください。

もう1つの課題はデータ活用(機械学習含む)によってCVR向上を通して利益貢献に結びけることに成功した一方で、既存サービスにパッチを当てるような機械学習の使い方ではその成果がサービスの競争優位性構築に結びつけるまでには至らなかったことです。そこで利益貢献を維持しながらデータ活用によってCVR向上よりも大きな成果、サービス自体の競争優位性構築に貢献することが2016年以降のグループのテーマになっていきます。これは現時点で100のサービスをを105にするためではなく中長期的に200、300に延ばしていくために機械学習を始めとするデータ活用を進めて行くということです。

パッチからデザインへ

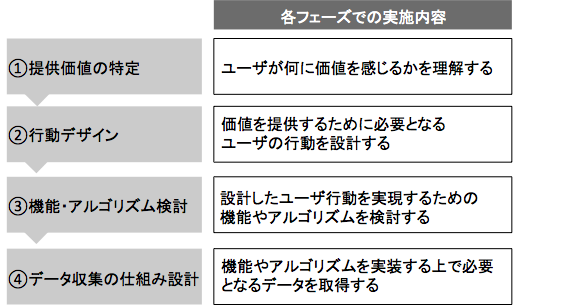

この方針のもと2016年以降はアルゴリズムの洗練化 を継続しつつ、ユーザ体験の設計段階まで踏み込むプロジェクトを継続的に立ち上げています。これは機械学習がサービスと切り離された機能として提供されるのではなく、サービスの中核を担う行動デザインとインタラクションデザインのレイヤーから関わることを意味します。少し前にGoogle Design blogの記事「Humuman-centerd Machine learning と類似した取組みをリブセンスにおいても約1年前から行っており、次のようなプロセスでプロジェクトを回しています。

このプロセスのポイントは「既存のデータから機械学習で出来ることを考える」から「コンセプトを先に決めて必要なデータをすべて取る」という方式に変更した点です。Webサービスにおいて機械学習はあくまでユーザへの価値提供を実現するための強力な選択肢の1つであると考え、機械学習ありきではなくユーザへの価値提供を最上位におき、提供価値の具体化と行動デザインのフェーズで機械学習の活用を検討している点で人間中心な機械学習と言えるでしょう。

人間中心の機械学習の実施プロセス

ここからはフェーズ①〜②においてリブセンスで実際に行っている具体的なプロセスをご紹介します。基本的にはISO9241-210にて定義されているHCDのプロセスをベースにしています。まだまだ試行錯誤の日々ですが現在我々のチームでは次のステップで進めています。

ターゲットセグメントの決定

まず最初にターゲットになりうるユーザを対象に幅広くデプスインタビュー行い、定性分析によるユーザセグメンテーションを行います。セグメントの軸には様々な方法がありますが我々のチームでは行動パターンの類似性で切り分けた後にメインターゲットとするセグメントを決定しています。ユーザの価値抽出

ターゲットセグメントに属するユーザの価値感の抽出分析を行います。デプスインタビューで得た発言録からユーザの行為と意図を抽出して分析を行うことでユーザのもつ本質的欲求を分析します。手法はいくつかありますが、時間がないときは上位下位関係分析、余裕があるときはKJ法やKA法などを用いることが多いです。その後As-isのカスタマージャーニーマップを作成して現在のユーザ行動やタッチポイントごとの課題を可視化します。期間と予算の関係上分析のデータソースとしてはstep1で行ったデプスインタビューの結果を再利用することが多いです。コンセプト設計とユーザ体験の可視化

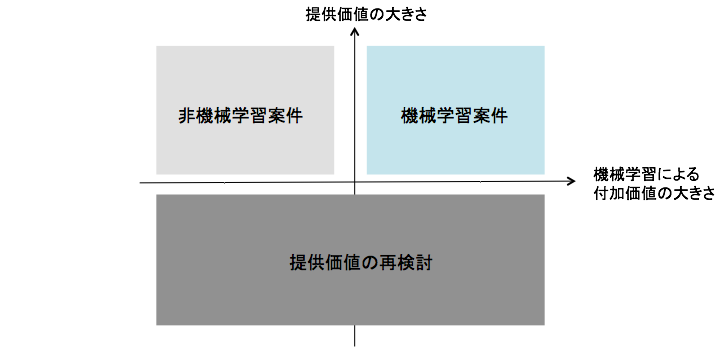

提供するユーザ体験のコアとなるコンセプトをプロジェクトメンバー全員で出し合います。この段階では提供価値にフォーカスしたいため一旦技術的なことは忘れます。次にコンセプトアイディアを「ユーザへの提供価値の大きさ」と「機械学習を使うことによる付加価値大きさ」の二次元マップ上に配置します。ここで高い提供価値を与えるアイディアの機械学習依存度が高い場合はデータサイエンティストとや機械学習エンジニアと実現可能性について検討を行います。ただしこの時点での確認はアイディアが荒唐無稽すぎたり、AIがなんとかするといった抽象的すぎるものになってないかなどの確認であって、具体的なアルゴリズム検討には踏み込みません。また機械学習依存度の低いアイディアの提供価値が一番大きいと判断された場合や機械学習を使うことにより効果が小さい場合は機械学習を使わない選択をすることも多いです。 仮コンセプト確定後は構造化シナリオ法を用いてユーザのサイト上における行動シナリオを可視化します。

コンセプト評価とプロトタイピング

ユーザインタビューによってコンセプト評価を行い、フィードバックを反映してコンセプトを修正していきます。例えば昨年度実施した転職会議の新機能のコンセプト設計では計3回のコンセプト修正と評価を行っています。定性だけで確信が持てない場合はコンセプトが固まった時点で定量アンケート調査で量的な担保を取る場合も多いです。また、プロトタイピングツールを使用してコンセプトをUIに落とし込んで実際にユーザ使ってもらった上での感想も聞いています。プロトの段階でアルゴリズムを開発するとコストが掛かりすぎるためレコメンドシステムであれば予めユーザに好みを聞いておいて人手で選んだ求人を見せたり、チャットボットであればUI上はボットに見せて裏側では人がやりとするようにして極力アルゴリズムを開発せずに擬似的な体験を提供してユーザ評価を行うようにします。- 開発プロジェクトへの展開

サービスリリースに向けてデザインプロセスに関わったメンバーを中心に開発プロジェクトを立ち上げます。この段階で機械学習エンジニアをプロジェクトメンバーに本格的にアサインして具体的なアルゴリズムの検討を開始します。

このプロセスでは機械学習の利用を前提とせず提供価値に着目していますが、一方で最初から機械学習の活用アイディアがあるケースもよくあるかと思います。その場合は調査からスタートすると時間がかかりすぎるのでstep1〜step3をプラグマティックペルソナで代替して高速にアイディアの検証とピボットを繰り返していくことで効率的にプロジェクトを進めていく方法をとるのが良いのではないかと考えています。

以上がリブセンスで行っている機械学習を活用したおおまかな体験設計のプロセスです。直近の事例では就活会議での就活生と企業のマッチング機能をこのプロセスを採用して設計しています。アルゴリズム改善のみでマッチング精度を上げるのではなく、就活会議に訪れたユーザが適性な企業とのマッチングに至るまでに必要なユーザの体験設計を最初に行い、ユーザ体験がユーザに刺さるかどうかを事前検証後に必要な機能・アルゴリズム・データを収集・開発しています。就活会議における具体的なサービス設計の事例についてはまた別の機会にご紹介できればと思います。